VIENI A TROVARCI

Sede Operativa:Via Stelvio, 24

23020 Poggiridenti (SO) | ITALIA

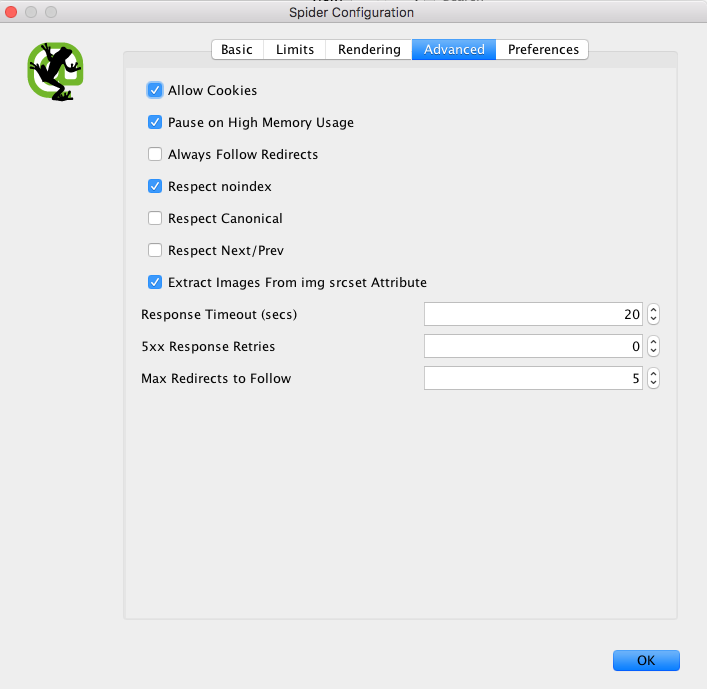

Normalmente gli Spider di Google e degli altri motori di ricerca non accettano i cookies di default, nel caso in cui il nostro Seo Audit necessiti di scansionare un sito che li preveda dovremo cambiare delle impostazioni di default di Screaming Frog.

SPIDER CONFIGURATION → TAB “ADVANCED” → “ALLOW COOKIES”

Screaming Frog permette di simulare il “crawler” modificando anche lo “User Agent”. Potremo scegliere fra le seguenti opzioni:

Questa opzione sarà attivabile seguendo questi steps:

CONFIGURATION → HTTP HEADER → USER AGENT

SEO TIPS: quando andiamo a progettare un nuovo sito internet una delle fasi cruciali è sicuramente quella della pre-pubblicazione online.

In questa fase l’ultimo Seo Audit è molto importante per controllare che tutti gli elementi del sito siano “Seo Friendly” e ben configurati. In questa fase per “crawlerarlo” lo dobbiamo fare vedere allo Spider sbloccando il “Robots.txt” con il rischio che Google, Yahoo o Bing lo intercettino e indicizzino creando poi al sito definitivo il possibile problema di “Contenuto duplicato”.

A questo punto il metodo più sicuro è quello di bloccare il dominio a tutti gli spider e sbloccare solo quello di Screaming Frog. Vediamo cosa inserire nel file:

User-agent: * Disallow: / User-agent: Screaming Frog SEO Spider Allow: /

Allo stesso modo possiamo far crawlerare un sito attraverso la scelta di un “Proxy”. Basterà selezionare la funzione “Proxy” da:

CONFIGURATION --> PROXY

La configurazione comprenderà la compilazione di due campi:

Quando eseguiamo una scansione di un sito con pagine protette da password ma abbiamo la necessità di farle crawlerare al BOT dovremo:

CONFIGURATION → “AUTHENTICATION”

SEO TIPS: Attenzione a fare scansionare pagine interne ai Cms protetti da password. Il crawler proverà a cliccare tutti i link presenti, quindi se ci sono funzionalità come “aggiungi data/pagine o altro “ o “cancella dati/pagine/ordini...” il crawler lo farà e potrebbe perdervi o rivoluzionarvi il contenuto in pochi secondi.

Se si decide di utilizzare lo Spider ugualmente è consigliabile escludere le funzionalità più invasive per limitare eventuali danni.